融云开源 MCP Server,让大模型轻松调用 IM 能力

现在开始,在 AI 开发平台或大模型中,开发者可以通过统一的标准协议,更加便捷地调用融云 IM 接口啦。

近期,融云上线 MCP Server,将 IM 能力封装为模型可调用的工具服务,打通了模型与用户、群组之间的智能互动通路。

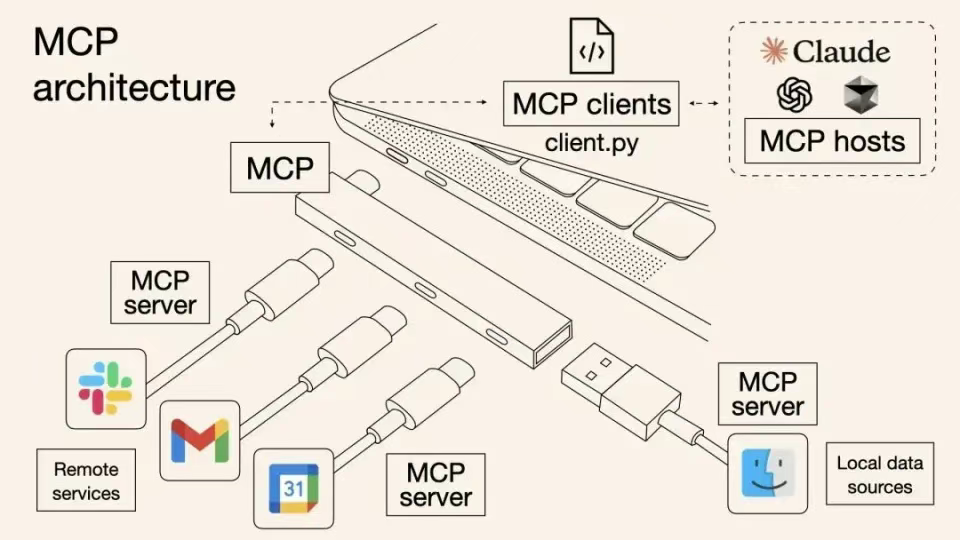

MCP 是一个标准协议,被类比为 AI 应用中的 USB-C 接口。通过标准化的接口规范,使 AI 大模型能够以统一的方式连接各种外部工具和数据源。

相较此前大模型标准不一的 Function Calling 方式,MCP 的标准化统一带来了更低的开发成本、更高的复用性和更强的灵活性,在跨平台数据整合与协作场景中优势尤为明显。

作为新的统一连接神经,MCP 生态正在不断丰富,它打破了 AI 大模型与外部工具、互联网资源的壁垒,赋予用户在各个支持 MCP 的 AI 产品中自由地访问文件、调用 API、操作工具等能力。

这意味着,AI 将具备更强的动态交互能力,让调用外部工具完成复杂任务的 Agent 更具落地性。通过融云 MCP Server,配合其他支持 MCP 的 AI 工具及平台,开发者可以更便捷地实现大模型内容生成和自动化分发、用户和群组管理等能力,适用智能客服、企业协同、用户运营及广泛的待扩展场景。

适用场景

支持用户在大模型中通过自然语言实现私聊、群聊交互——

快速搭建产品原型,比如开发者在调试 AI 产品时可以直接在大模型中用自然语言测试消息发送、群组创建/解散等能力。

支持直接从大模型端向客户端发送 AI 生成的消息内容,可用于 AI 客服、产品运营等场景。

在企业协同场景,支持由大模型分析并总结指定用户的对话内容;借助大模型的对话理解能力,实现群组成员的智能管理,如:

自动邀请成员加入群组(“@张三 加入项目群” 或 “可以把小李拉进来一起参与”);

自动将成员移出群组(“张三说话不合适,踢出群” 或 “@AI 踢掉李四”);

查询当前群组成员信息(“群里现在有谁?”或“请列出这个群的成员名单”);

批量解散群聊(“解散群组 group-001、group-002 和 group-003”或“批量解散指定的多个群组”)。

快速部署

支持云端托管(SSE)、本地集成(STDIO)两种接入模式。

开发者可以根据情况选择合适的方式配置融云 MCP Server,进而使用私聊、群聊、私聊历史消息、群组管理等工具能力,实现用户社交互动与群组管理功能。

准备工作

在开始集成 MCP Server 之前,请确保:

☑ 已在融云控制台创建应用,并获取有效的 App Key / App Secret。

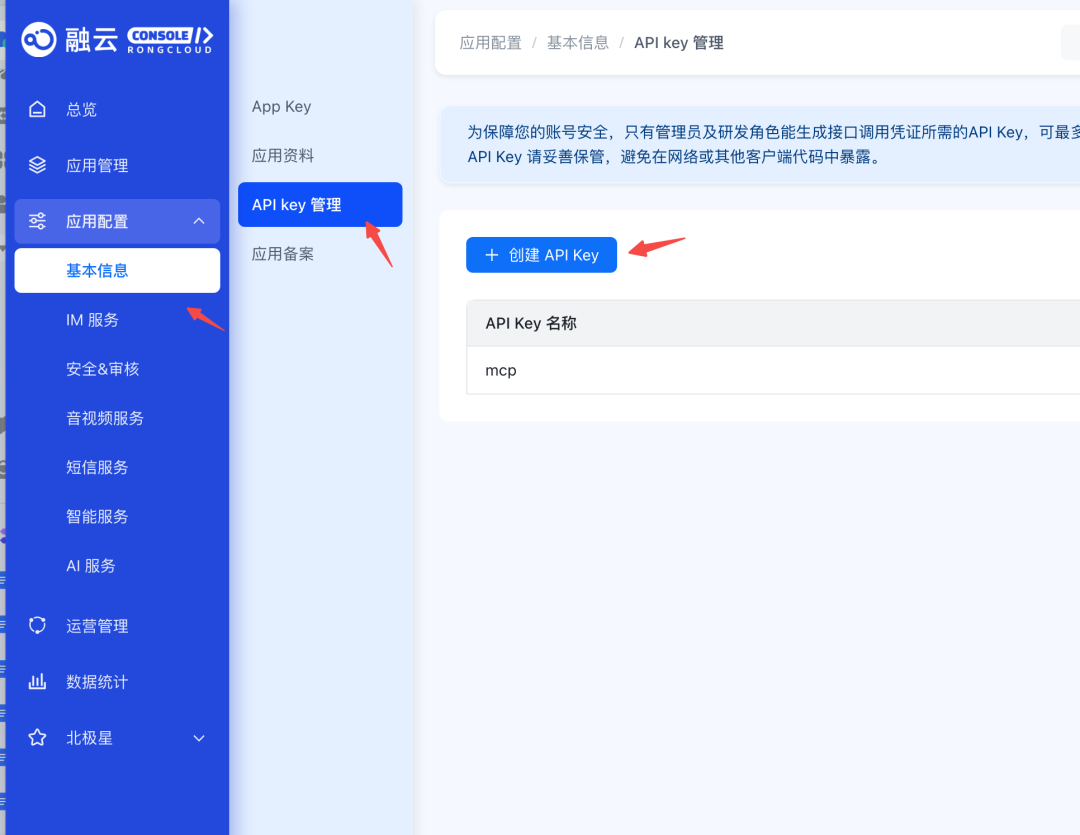

☑ 若使用托管模式(SSE),请在融云控制台创建 API Key,用于身份验证。

SSE 模式接入

官方托管部署,免运维;模型远程调用访问,多端共享、轻量接入。

接入步骤

☑ 获取 API Key,前往融云控制台申请或查看对应的 API Key。

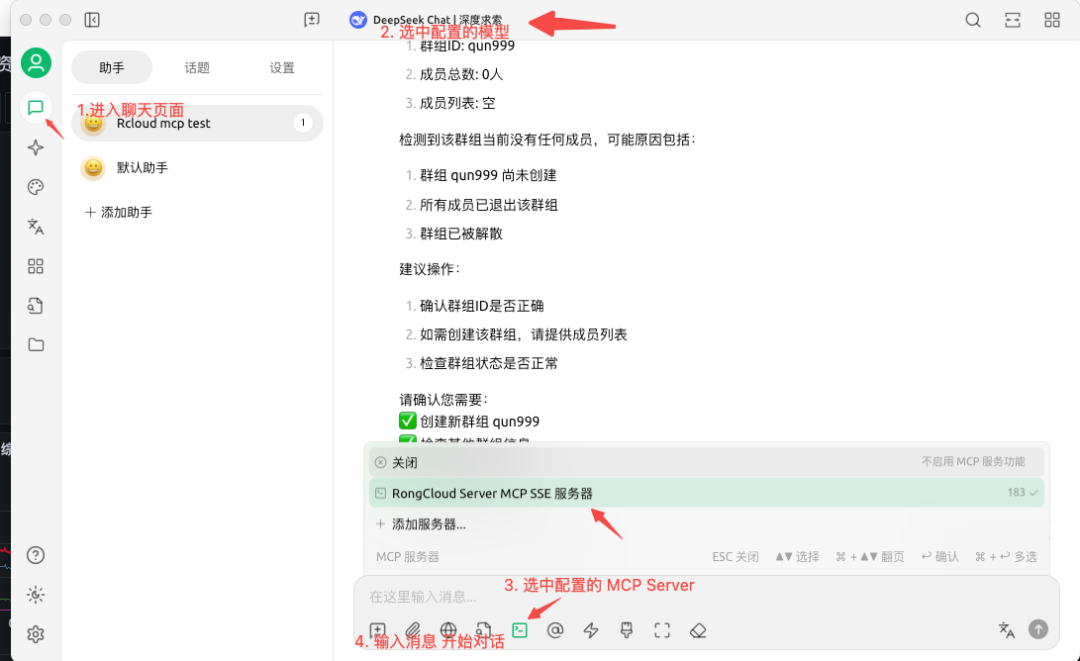

☑ 配置 MCP Server(以 Cherry Studio 为例)

▪打开 Cherry Studio 的 MCP 服务器设置页

▪点击“添加服务器(从 JSON 导入)”

▪填写以下配置信息:

{"mcpServers": {"rongcloud-server-mcp-sse": {"type": "sse","url": "https://ai.rong-api.com/mcp/sse?api_key=your_api_key" }}}

如果提示添加失败,可关闭设置页面后手动保存配置即可生效

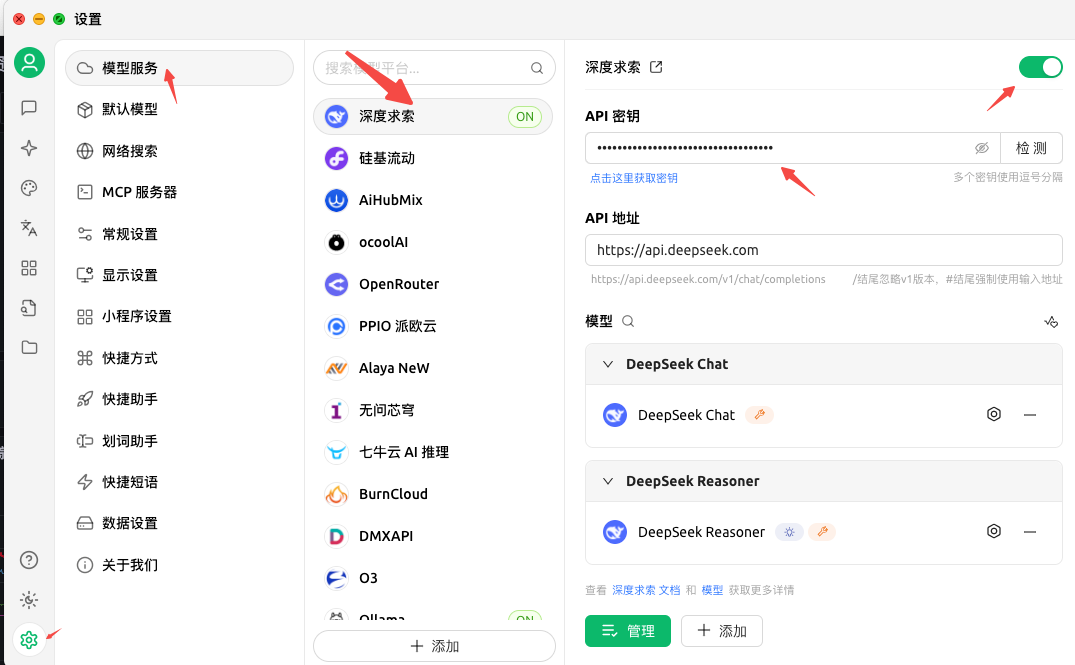

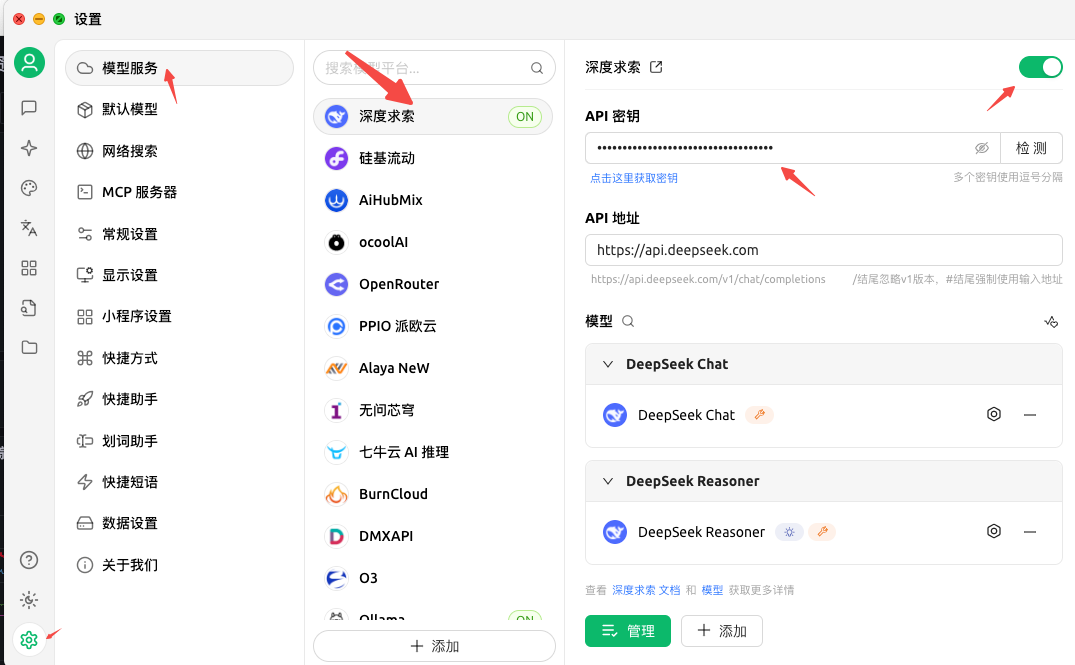

▪打开 Cherry Studio 的“模型服务设置”页面,选择并启用一个聊天模型,然后在对应位置填写 API 密钥(可在该模型的官网申请)。

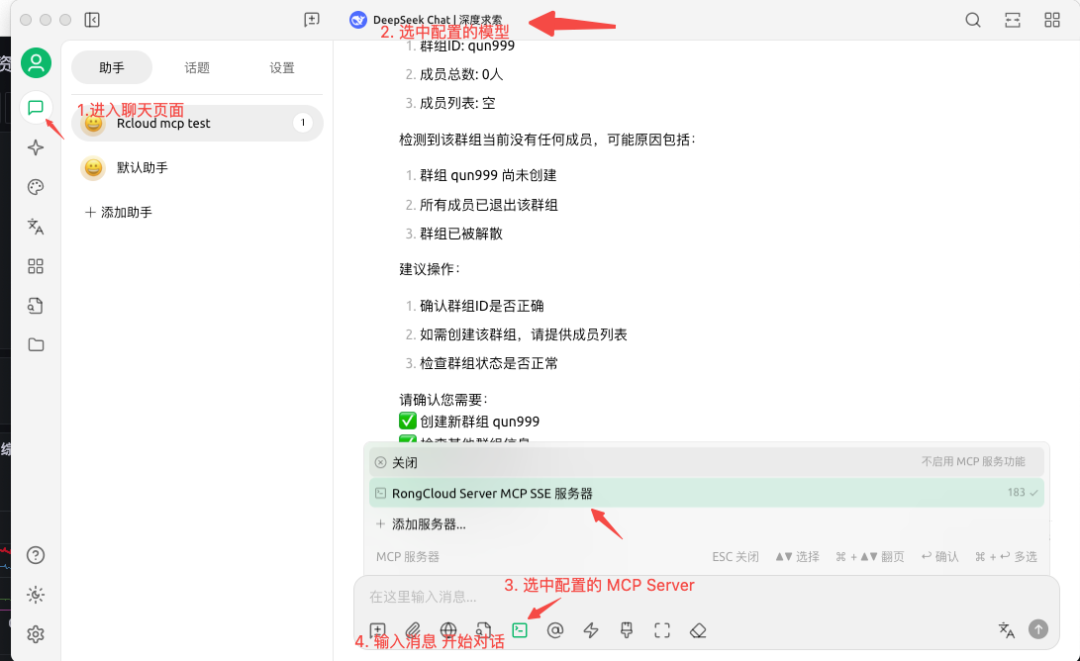

▪打开 Cherry Studio 的“聊天”页面,选择所需的聊天模型,并勾选已配置的 MCP。完成后,输入消息即可开始对话。

STDIO 模式接入

本地部署,低延迟响应,支持二次开发与调试。

接入步骤

☑ 安装 UV 工具

# macOS / Linux 安装curl -LsSf https://astral.sh/uv/install.sh | sh# Windows 安装powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"# 或使用 pip 安装pip install uv

(仅 macOS)安装 coreutils

brew install coreutils配置 MCP Server(以 Cherry Studio 为例)

▪打开 Cherry Studio 的 MCP 服务器设置页

▪点击“添加服务器(从 JSON 导入)”

▪填入以下配置信息:

{"mcpServers": {"rongcloud-server-mcp-python": {"command": "uvx","args": ["rongcloud-server-mcp-python"], "env": { "RONGCLOUD_APP_KEY": "your_app_key","RONGCLOUD_APP_SECRET": "your_app_secret","RONGCLOUD_API_BASE": "https://api.rong-api.com" }}}}

☑ 打开 Cherry Studio 的“模型服务设置”页面,选择并启用一个聊天模型,然后在对应位置填写 API 密钥(可在该模型的官网申请)。

☑ 打开 Cherry Studio 的“聊天”页面,选择所需的聊天模型,并勾选已配置的 MCP。完成后,输入消息即可开始对话。

使用示例

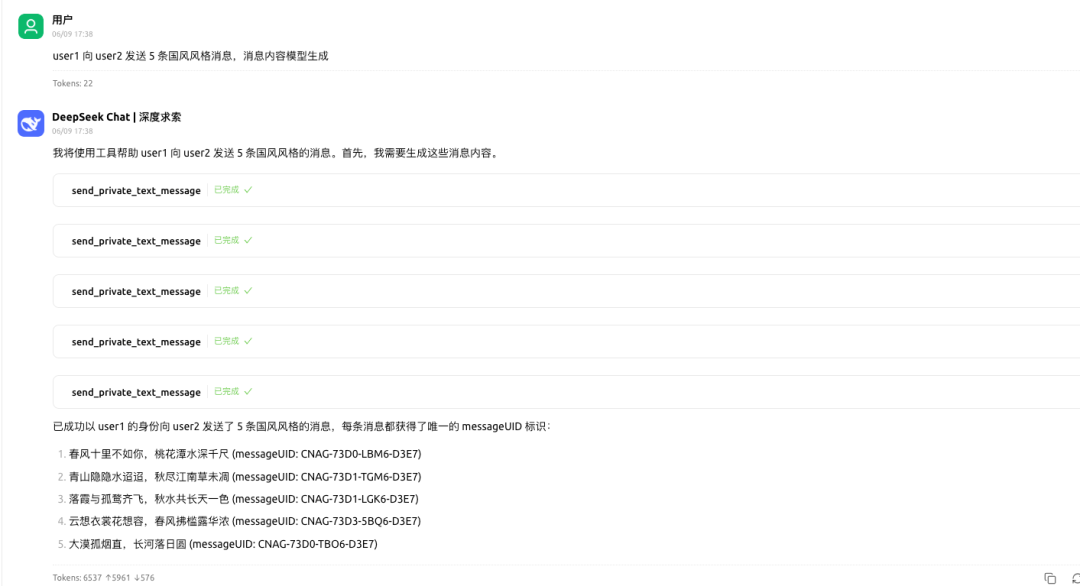

发送消息,如 user1 向 user2 发送 5 条国风风格消息,消息内容自动生成。

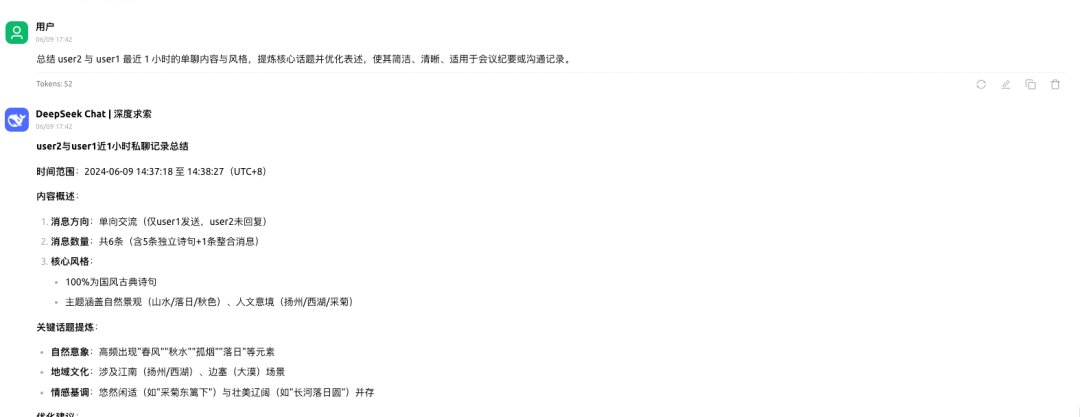

消息总结,如总结 user2 和 user1 最近 1 小时的单聊内容与风格,提炼核心话题并优化表述,使其简洁、清晰、适用于会议纪要或沟通记录。

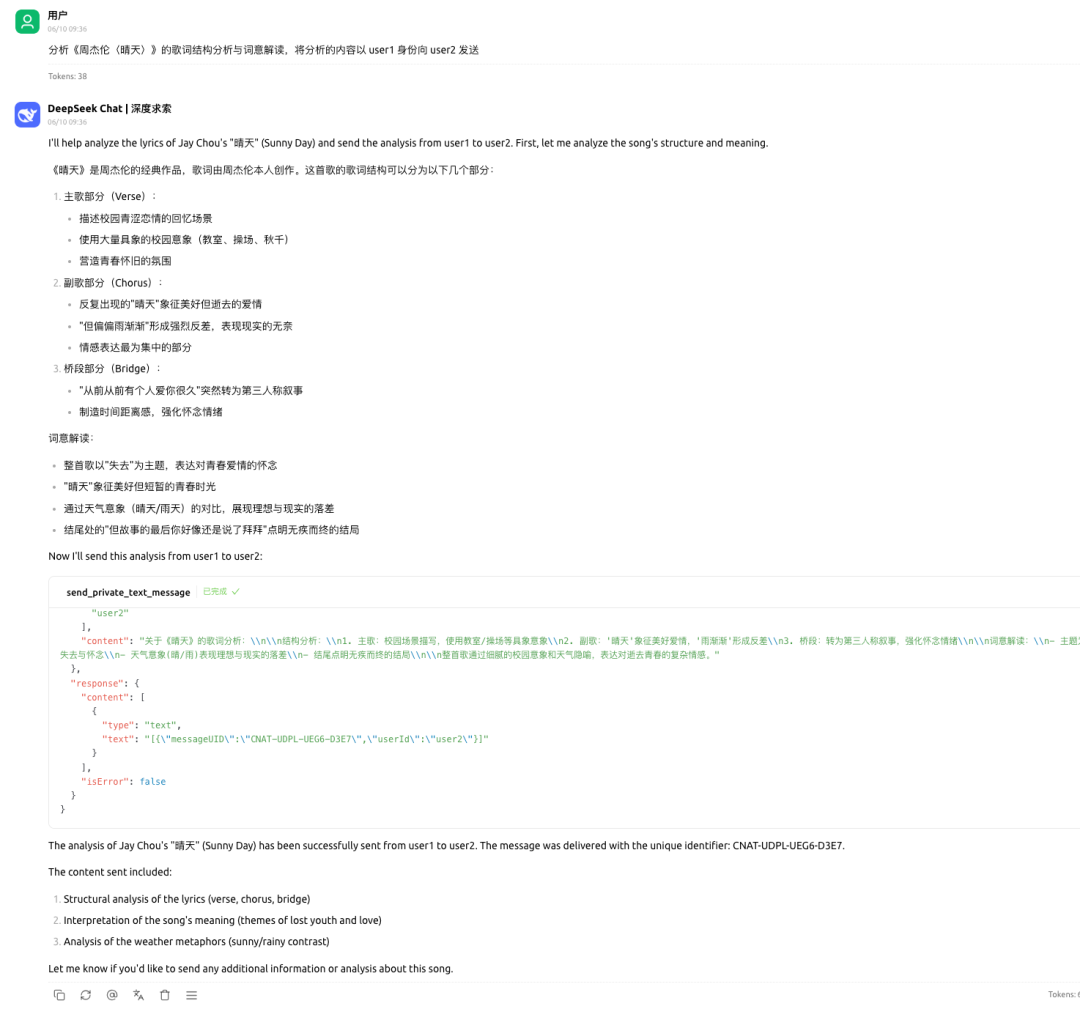

自动生成内容发送到用户终端,如分析《周杰伦〈晴天〉》的歌词结构分析与词意解读,将分析的内容以 user1 身份向 user2 发送。

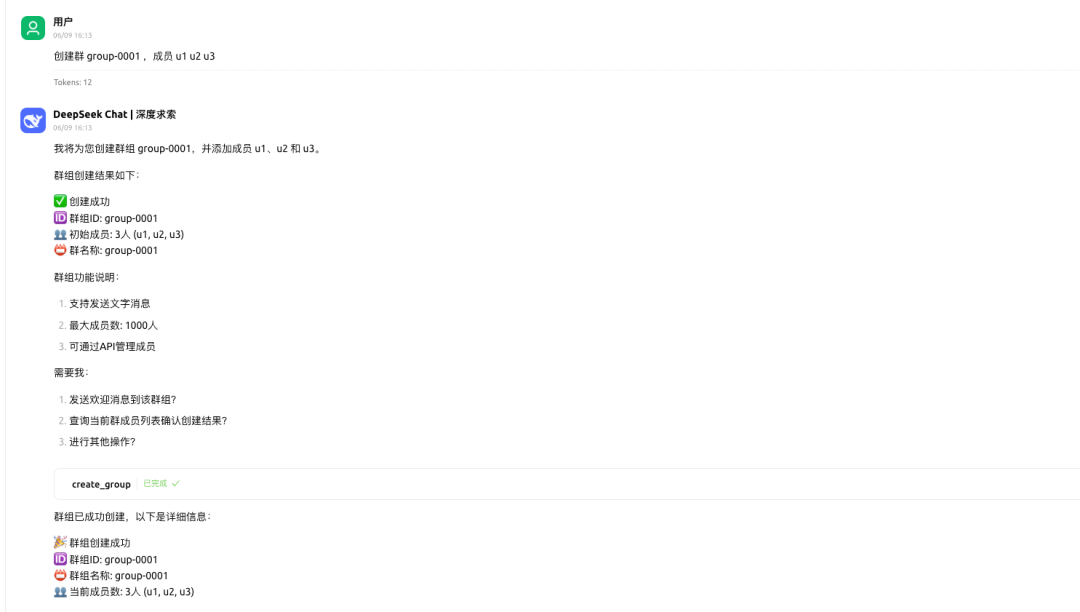

邀请成员加入群聊

▪创建一个群,群名叫“项目讨论组”,初始成员包括 u1, u2, u3。

▪邀请成员加入到群聊,把 u4 拉进来一起参与, 群 ID 为 group-0001

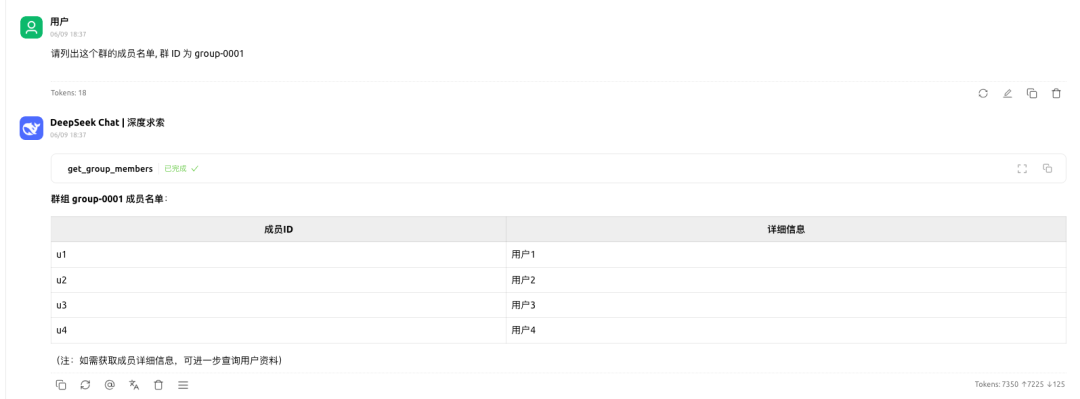

查询群成员列表,如请列出这个群的成员名单, 群 ID 为 group-0001

解散群组,如解散群组 group-001、group-002 和 group-003

项目仓库地址

开发者文档:

Server MCP 概述 | 融云开发者文档

项目仓库地址:

GitHub:

rongcloud/rongcloud-server-mcp-python

rongcloud/rongcloud-native-mcp-python

Gitee:

rongcloud/rongcloud-server-mcp-python

rongcloud/rongcloud-native-mcp-python

预约咨询专属顾问

预约咨询专属顾问